Acabamos de entrar en la era de la supremacía cuántica, sugiere un nuevo estudio.

Por primera vez, una computadora cuántica ha resuelto un problema que una computadora tradicional, a todos los efectos prácticos, no puede, los investigadores informaron hoy (23 de octubre) en la revista Nature.

“Un cómputo que tomaría 10,000 años en una supercomputadora clásica tomó 200 segundos en nuestra computadora cuántica”, coautor del estudio Brooks Foxen, un investigador estudiantil graduado en física en Google AI Quantum en Mountain View y la Universidad de California, Santa Bárbara, dijo en un comunicado.

“Es probable que el tiempo de simulación clásico, actualmente estimado en 10,000 años, se reduzca con hardware y algoritmos clásicos mejorados, pero, dado que actualmente somos 1,5 billones de veces más rápido, nos sentimos cómodos al reclamar este logro”, agregó Foxen.

Las computadoras cuánticas almacenan información utilizando partículas subatómicas, que se comportan de acuerdo con reglas muy diferentes a las que rigen nuestro macro mundo. Por ejemplo, las partículas cuánticas pueden existir en una “superposición” de dos estados diferentes al mismo tiempo, y las partículas pueden estar separadas por años luz y aún estar “enredadas”, afectando las propiedades de los demás.

Esta rareza es clave para el increíble poder potencial de la computación cuántica. Debido al fenómeno de superposición, las computadoras cuánticas pueden almacenar y manipular mucha más información por unidad de volumen que las computadoras tradicionales, que codifican la información de forma binaria usando 0s y 1s. (La unidad básica de información en un sistema de computación cuántica, por cierto, se conoce como qubit, que es la abreviatura de “bit cuántico”).

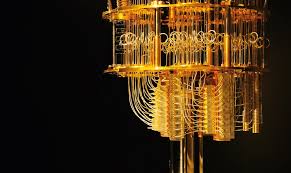

El nuevo estudio nos da una idea de ese poder. El equipo de investigación, dirigido por Frank Arute de Google AI Quantum, utilizó una computadora cuántica llamada Sycamore, que presentaba 53 qubits funcionales (más uno que no funcionaba correctamente).

Los científicos enredaron esos 53 qubits en un estado complejo de superposición, luego hicieron que Sycamore realizara una tarea similar a la generación de números aleatorios. Luego, los resultados se compararon con simulaciones realizadas en la supercomputadora Summit en el Laboratorio Nacional Oak Ridge en Tennessee.

“Summit es actualmente la supercomputadora líder en el mundo, capaz de llevar a cabo alrededor de 200 millones de millones de operaciones por segundo”, escribió William Oliver, físico del Instituto de Tecnología de Massachusetts, en un artículo adjunto de “Noticias y puntos de vista” en el mismo número de Nature. .

“Comprende aproximadamente 40,000 unidades de procesador, cada una de las cuales contiene miles de millones de transistores (interruptores electrónicos) y tiene 250 millones de gigabytes de almacenamiento. Aproximadamente el 99% de los recursos de Summit se utilizaron para realizar el muestreo clásico”, agregó Oliver, que no participó en el nuevo estudio

Como señaló Foxen, Sycamore terminó en aproximadamente 3,5 minutos, y el trabajo de la Cumbre sugirió que incluso la supercomputadora tradicional más poderosa tendría que analizar el problema durante aproximadamente 10,000 años.

“Esta demostración de supremacía cuántica sobre los algoritmos clásicos líderes de la actualidad en las supercomputadoras más rápidas del mundo es realmente un logro notable y un hito para la computación cuántica”, agregó Oliver. “Sugiere experimentalmente que las computadoras cuánticas representan un modelo de computación que es fundamentalmente diferente al de las computadoras clásicas. También combate las críticas sobre la capacidad de control y la viabilidad de la computación cuántica en un espacio computacional extraordinariamente grande (que contiene al menos los 253 estados utilizados aquí) ) “.

Oliver también enfatizó, sin embargo, que aún queda mucho trabajo por hacer antes de que las computadoras cuánticas puedan convertirse en una parte importante de nuestra vida cotidiana. Por ejemplo, escribió, los investigadores tendrán que desarrollar nuevos algoritmos que puedan funcionar con los procesadores cuánticos propensos a errores que estarán disponibles en el futuro cercano. Y, para que la tecnología sea comercialmente viable a largo plazo, los científicos tendrán que idear protocolos robustos para corregir los errores cuánticos.